搜索引擎蜘蛛是怎么样抓取网站页面内容的

>了解搜索引擎的工作原理是学习seo技术非常重要的内容,比如了解搜索引擎蜘蛛的爬行机制,只有深入了解这些内容,才能真正了解关键词排名的原理,seo优化做什么等等。今天石家庄seo博客和朋友分享了搜索引擎蜘蛛是如何抓取网站页面内容的,文字是从网络转载的。

互联网信息的爆炸式增长,如何有效地获取和利用这些信息是搜索引擎工作的首要环节。数据采集系统作为整个搜索系统的上游,主要负责收集、保存和更新互联网信息。它像蜘蛛一样在网络上爬行,所以通常被称为“蜘蛛”。比如几种常用的搜索引擎蜘蛛,叫做Baiduspdier、Googlebot、搜狗Web Spider等等。

互联网信息的爆炸式增长,如何有效地获取和利用这些信息是搜索引擎工作的首要环节。数据采集系统作为整个搜索系统的上游,主要负责收集、保存和更新互联网信息。它像蜘蛛一样在网络上爬行,所以通常被称为“蜘蛛”。比如几种常用的搜索引擎蜘蛛,叫做Baiduspdier、Googlebot、搜狗Web Spider等等。

蜘蛛爬行系统是搜索引擎数据源的重要保证。如果把web理解为一个有向图,那么Spider的工作过程可以看作是遍历这个有向图。从一些重要的种子URL开始,通过页面上的超链接关系,不断发现新的URL并进行抓取,从而抓取尽可能多的有价值的网页。对于百度这样的大型蜘蛛系统来说,由于存在网页被修改、删除或一直出现新超链接的可能性,所以需要保持蜘蛛抓取的页面更新,并维护一个URL库和一个页面库。

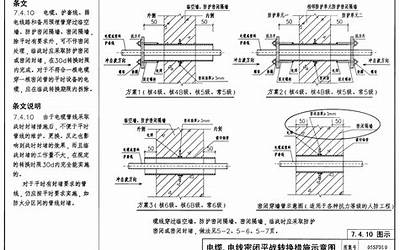

下图是蜘蛛抓取系统的基本框架,包括链接存储系统、链接选择系统、dns解析服务系统、抓取调度系统、网页分析系统、链接提取系统、链接分析系统和网页存储系统。Baiduspider就是通过这个系统的配合来完成抓取网页的工作。

Baiduspider的主要爬行策略类型

上图看似简单,但Baiduspider在爬行的过程中其实面对的是一个超级复杂的网络环境。为了让系统抓取尽可能多的有价值的资源,并保持系统与实际环境的页面一致性,而不造成网站体验的压力,会设计很多复杂的抓取策略。以下是简要介绍:

1.抓住友善

互联网资源在数量级上是巨大的,这就要求捕获系统在有限的硬件和带宽资源下,尽可能高效地利用带宽,捕获尽可能多的有价值的资源。这就引出了另一个问题,就是被抓取网站的带宽消耗造成了访问压力,会直接影响到被抓取网站的正常用户访问行为。因此,在抓取过程中,需要控制抓取压力,以达到在不影响网站正常用户访问的情况下,尽可能捕捉到有价值资源的目的。

通常,最基本的压力控制是基于ip的。这是因为如果是基于域名,可能会出现一个域名对应多个ip(很多大网站)或者多个域名对应同一个IP(小网站共享IP)的问题。在实践中,压力调节控制往往是根据ip和域名的各种情况来进行的。同时,站长平台也推出了压力反馈工具,站长可以手动调整自己网站上的抓取压力。这时候百度蜘蛛会根据站长要求优先进行爬行压力控制。

同一个站点的抓取速度控制一般分为两类:一是一段时间内的抓取频率;第二,捕捉一段时间内的流量。同一站点在不同时间的爬行速度会有所不同。比如晚上天黑,风大的时候可能更快。也要看具体的站点类型。主要思路是错开正常用户高峰访问量,不断调整。对于不同的站点,也需要不同的抓取速度。2.常用的抓取返回代码指示

简单介绍一下百度支持的几个返回码:

1)最常见的404代表“NOT FOUND”,表示网页已经过期,通常会在库中删除。同时,如果spider在短期内再次找到这个url,它将不会爬行;

2)503代表“服务不可用”,表示网页暂时无法访问。通常网站暂时关闭,带宽有限。对于网页返回的503状态码,百度蜘蛛不会直接删除这个网址,会在短时间内多次访问。如果网页已经恢复,则正常抓取;如果你继续返回503,这个网址仍然会被认为是一个无效的链接,并从库中删除。

3)403代表“禁止”,认为网页目前禁止访问。如果是新的url,spider暂时不会抓取,短时间内也会访问几次;如果是包含的网址,不会直接删除,短时间内会被访问几次。网页正常访问的,正常抓取;如果访问仍然被禁止,该网址也将被视为无效链接,并从库中删除。

4)301代表“永久移动”,这意味着网页被重定向到一个新的网址。如遇网站迁移、域名变更、网站改版,建议使用站长平台的301返回码和网站改版工具,减少改版造成的网站流量损失。

3.多个url重定向的标识

由于各种原因,互联网上的一些网页具有网址重定向状态。为了正常抓取这些资源,蜘蛛需要识别和判断网址重定向,防止作弊。重定向可以分为三类:http 30x重定向、元刷新重定向和js重定向。此外,百度还支持Canonical标签,实际上可以认为是间接重定向。

4.抢占优先级分配

由于互联网资源规模的巨大而快速的变化,搜索引擎几乎不可能捕捉到所有的资源并合理更新以保持一致性。因此,爬行系统需要设计一套合理的爬行优先级分配策略。主要包括深度优先遍历策略、宽度优先遍历策略、pr优先策略、反链策略、社会共享引导策略等。每种策略各有利弊。在实践中,多种策略经常结合使用,以达到最佳的捕捉效果。

5.重复url过滤

蜘蛛在抓取过程中需要判断一个页面是否被抓取过。如果它还没有被抓取,它将抓取网页并将其放入抓取的网址集中。判断是否被抓取的核心是快速搜索和比较,还涉及到url规范化识别。例如,一个url包含大量无效参数,实际上是同一个页面,将被视为同一个url。

6.暗网数据采集

网上有很多搜索引擎暂时捕捉不到的数据,叫做暗网数据。一方面,网络数据库中存在许多网站的大量数据,蜘蛛很难通过抓取网页获得完整的内容;另一方面,由于网络环境、网站本身不符合标准、孤岛等原因,也会造成搜索引擎无法抓取。目前,从黑暗网络获取数据的主要方式仍然是通过开放平台提交数据,如百度站长平台和百度开放平台。

7.抢防作弊

蜘蛛在爬行过程中经常会遇到所谓的黑洞或者大量的低质量页面,这就要求在爬行系统中要设计一个完善的防作弊系统。比如分析网址特征,分析页面大小和内容,分析网站规模对应的抓取规模。

Baiduspider爬行中涉及的网络协议

刚刚提到百度搜索引擎会设计复杂的抓取策略。事实上,搜索引擎和资源提供者之间存在一种相互依赖的关系,其中搜索引擎需要站长为其提供资源,否则搜索引擎无法满足用户的检索需求;网站管理员需要通过搜索引擎推广他们的内容,以获得更多的受众。蜘蛛爬行系统直接关系到互联网资源提供商的利益。为了实现搜索引擎和站长的双赢,双方在爬行过程中都必须遵守一定的规范,以方便双方的数据处理和对接。在这个过程中观察到的标准也是我们日常调用的一些网络协议。

以下是一个简短的列表:

Http协议:超文本传输协议是互联网上使用最广泛的网络协议,是客户端和服务器请求和响应的标准。一般来说,客户端指的是终端用户,服务器指的是网络站。最终用户通过浏览器、蜘蛛等向服务器的指定端口发送http请求。发送http请求会返回相应的httpheader信息,包括是否成功、服务器类型、网页的最新更新时间等等。

Https协议:其实是http的加密版,更安全的数据传输协议。

UA属性:UA是用户代理,这是http协议中的一个属性。它代表了终端的身份,向服务器展示了我是谁,为什么是我,然后服务器可以根据不同的身份做出不同的反馈结果。

Robots protocol: robots.txt是搜索引擎访问网站时首先访问的文件,用于确定哪些是允许抓取的,哪些是禁止抓取的。Robots.txt必须放在网站的根目录下,文件名要小写。机器人的详细写法请参考http://www.robotstxt.org。百度严格遵守机器人协议。此外,百度还支持在网页内容中添加名为robots、index、follow、nofollow等说明的元标签。

拜迪斯皮德抓频原理及调整方法

Baiduspider按照上面网站设置的协议抓取站点页面,但是不可能平等对待所有站点。它会综合考虑站点的实际情况确定一个抓取配额,每天对站点内容进行量化抓取,这就是我们常说的抓取频率。那么百度搜索引擎根据什么指标来确定一个网站的抓取频率呢?有四个主要指标:

1、网站更新频率:更新更快,更新更慢,直接影响Baiduspider的访问频率

2.网站更新质量:更新频率增加,只吸引了Baiduspider的注意力。Baiduspider对质量要求严格。如果百度蜘蛛每天更新的大量内容被判定为低质量页面,那还是没有意义的。

3.连接性:网站要安全稳定,对Baiduspider保持开放。让拜杜斯皮德闭嘴不是好事。

4、站点评价:百度搜索引擎会对每个站点都有一个评价,这个评价会根据站点情况不断变化,这是百度搜索引擎对站点的一个基本评分(绝不是外界所说的百度权重),是百度内部非常机密的数据。网站评级从来不是独立使用的,会和其他因素、阈值一起影响网站的抓取和排名。

爬行频率间接决定了数据库中可以包含多少网站页面。这么重要的一个值,如果没有达到站长的预期,该如何调整?百度站长平台提供了一个抓取频率的工具,已经多次升级。该工具除了捕捉统计数据外,还提供了“频率调整”功能。站长要求Baiduspider根据实际情况增减访问量,工具会根据站长意愿和实际情况进行调整。

拜杜斯皮德异常抓握的原因

有一些高质量内容的网页,用户可以正常访问,但是Baiduspider无法正常访问和抓取,导致搜索结果覆盖面不足,对百度搜索引擎和站点都是一种损失。百度称这种情况为“非正常爬行”。对于大量内容无法正常抓取的网站,百度搜索引擎会认为网站在用户体验上存在缺陷,降低对网站的评价,在抓取、索引、排序上会有一定程度的负面影响,最终影响网站从百度获得的流量。

下面是一些常见的对站长进行异常抓取的原因:

1.异常服务器连接

服务器连接异常有两种情况:一种是站点不稳定,Baiduspider在尝试连接你网站的服务器时暂时无法连接;一个是Baiduspider已经无法连接到你网站的服务器。

服务器连接异常的原因通常是你的网站服务器太大,过载。也有可能是您的网站工作不正常。请检查网站的web服务器(如apache、iis)是否安装运行正常,并使用浏览器检查主页是否可以正常访问。您的网站和主机也可能会阻止Baiduspider的访问,因此您需要检查网站和主机的防火墙。

2.网络运营商异常:网络运营商分为电信和联通,Baiduspider无法通过电信或网通访问您的网站。如果出现这种情况,您需要联系网络服务运营商,或者购买双线服务的空间或购买cdn服务。

3.DNS异常:当Baiduspider无法解析您网站的IP时,会出现DNS异常。可能你的网站IP地址不对,或者域名服务商已经封杀了Baiduspider。请使用WHOIS或主机查询您网站的IP地址是否正确和可解析。如果不正确或未解决,请联系域名注册商更新您的IP地址。

4.IP ban: IP ban的意思是:限制网络的出口IP地址,禁止该IP段的用户访问内容,这里专门禁止BaiduspiderIP。只有当您的网站不想让Baiduspider访问时,才需要此设置。如果您想让Baiduspider访问您的网站,请检查BaiduspiderIP是否是在相关设置中错误添加的。也有可能是你网站所在的空间服务商已经封禁了百度IP,你需要联系服务商更改设置。

5.UA被禁止:UA是一个用户代理,服务器通过UA识别访问者的身份。当网站返回异常页面(如403,500)或跳转到其他页面访问指定的UA时,UA被禁止。只有当您的网站不想让Baiduspider访问时,才需要此设置。如果想让Baiduspider访问你的网站,在与useragent相关的设置中是否有Baiduspider UA,并及时修改。

6、死链:页面无效,不能向用户提供任何有价值信息的页面为死链,包括协议死链和内容死链:

协议死链:页面的TCP协议状态/HTTP协议状态明确指示的死链,如404、403、503状态等。

内容死链:服务器返回的状态正常,但内容已被更改为与原内容无关的信息页面,如不存在、已删除或需要权限等。

对于死链,我们建议站点使用协议死链,使用百度站长平台& # 8211;死链工具提交给百度,让百度更快找到死链,减少死链对用户和搜索引擎的负面影响。

7.异常跳转:将网络请求重定向到另一个位置是跳转。异常跳跃指以下情况:

1)目前该页面无效(内容删除,死链等。),所以直接跳转到上一个目录或者首页。百度建议站长删除这个无效页面的词条超链接。

2)跳转到错误或无效的页面

注意:百度推荐使用301跳转协议设置长时间跳转到其他域名的情况,比如更改网站域名。

8.其他例外:

1)针对百度参考的异常:网页针对百度参考返回不同于正常内容的行为。

2)针对百度ua的异常:网页向百度UA返回与页面原始内容不同的行为。

3)JS跳转异常:网页加载了百度无法识别的JS跳转代码,使得用户通过搜索结果进入页面后跳转。

4)压力过大导致的偶发性封禁:百度会根据站点大小、访问量等信息自动设定合理的抓取压力。但在异常情况下,如压力控制异常,服务器会根据自身负载进行保护性意外禁止。在这种情况下,请在返回代码中返回503(意思是“服务不可用”),因此Baiduspider会在一段时间后再次尝试爬网此链接,如果网站空闲,将会成功爬网。

判断新链接的重要性

好了,上面我们讲了影响Baiduspider正常抓取的原因。现在我们来说说Baiduspider的一些判断原则。在建立数据库之前,Baiduspide会对页面进行初步的内容分析和链接分析,通过内容分析确定页面是否需要索引数据库,通过链接分析找到更多的页面,然后抓取更多的页面——分析——是否建立数据库&发现新链接的过程。理论上,Baiduspider会爬回新页面上所有可以“看到”的链接,那么面对众多新链接,Baiduspider判断哪个更重要呢?两个方面:

首先,对用户的价值:

1、内容独特,百度搜索引擎喜欢独特的内容

2、主体突出,网页主要内容不突出,搜索引擎误判短页面为空,不抓取

3、内容丰富

4、广告是否合适

二、环节的重要性:

1、目录级-浅优先级

2.该链接在电台的受欢迎程度

百度优先建设重要图书馆的原则

Baiduspider抓多少页并不是最重要的,而是索引多少页,这就是我们常说的“建数据库”。众所周知,搜索引擎的索引数据库是分层的。高质量的网页会被分配到重要的索引数据库中,普通的网页会留在普通的数据库中,更差的网页会被分配到低级别的数据库中作为补充材料。目前60%的检索要求只能通过调用重要索引数据库来满足,这就解释了为什么有些网站收藏量极高却一直不尽人意。

那么,哪些网页可以进入优质索引数据库呢?其实一般原则是一个:对用户的价值。包括但不限于:

1、时效性和有价值的页面:这里,时效性和价值并列,缺一不可。有些网站为了制作时间敏感的内容页面,做了大量的收集工作,产生了一堆毫无价值的页面,百度不想看到。

2.高质量内容的专题页面:专题页面的内容可能不完全是原创的,即可以很好的整合各方内容,或者添加一些新鲜的内容,比如意见和评论,给用户更丰富、更全面的内容。

3.高价值原创内容页面:百度将原创定义为花费一定成本,积累大量经验后形成的文章。再也不要问我们伪原创是不是原创了。

4.重要个人页面:这里只是一个例子。科比在新浪微博上开了一个账号,需要他不要经常更新,但是对于百度来说还是一个很重要的页面。

哪些页面不能构建到索引库中

上面提到的优质网页已经进入索引数据库,但实际上互联网上大多数网站根本没有被百度收录。不是百度没发现他们,是建数据库前的筛选过程被过滤掉了。然后初期筛选出什么样的网页:1。内容重复的网页:百度当然不需要收录网上已有的内容。

2、空短页面的主要内容

1)有些内容使用了百度蜘蛛无法解析的技术,比如JS、AJAX。虽然用户在访问时可以看到丰富的内容,但仍然会被搜索引擎抛弃

2)加载速度太慢的网页也可能被视为空的短页面。注意网页整个加载时间中的广告加载时间。

3)很多主体不突出的网页即使爬回去也会被丢弃。

原文链接:http://www.sjzseo.net/1580.html,转载请注明出处。

评论0